在當今數據驅動的商業環境中,數據分析已成為企業決策的核心。而數據分析的起點與質量,很大程度上取決于其數據來源與處理方式。本文將深入解析數據分析中的兩個關鍵概念:接口數據源與數據處理服務,闡明它們是什么、如何工作以及為何至關重要。

一、 接口數據源:數據的“高速公路”入口

1. 核心定義

接口數據源,簡而言之,是數據分析系統通過標準化協議(如API、Web Service、JDBC/ODBC等)從外部系統實時或定期獲取數據的通道。它不是一個靜態的數據文件或數據庫表,而是一個動態的、程序化的數據接入點。

2. 主要類型與特點

API接口:目前最常見的形式,尤其是RESTful API和GraphQL。它允許系統通過HTTP請求(GET、POST等)從第三方服務(如社交媒體平臺、支付網關、SaaS應用)直接拉取結構化數據(通常是JSON或XML格式)。特點是靈活、實時性強,但通常有調用頻率限制。

數據庫接口:通過JDBC、ODBC等標準協議直接連接業務數據庫(如MySQL、Oracle、SQL Server)。適用于需要分析企業內部核心業務數據的場景,數據量大且結構穩定。

消息隊列接口:如Kafka、RabbitMQ等。用于接收實時流數據,適用于監控、日志分析、實時風控等對時效性要求極高的場景。

文件傳輸接口:通過FTP、SFTP或云存儲服務(如AWS S3、阿里云OSS)的API獲取批量數據文件(如CSV、Parquet)。

3. 在數據分析中的作用

接口數據源打破了數據孤島,使得分析系統能夠:

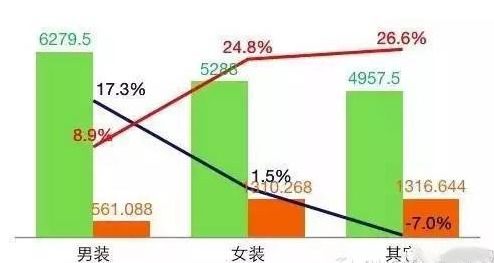

- 集成多源數據:將來自CRM、ERP、網站、App、物聯網設備等不同來源的數據匯聚一堂。

- 獲取實時數據:支持對實時業務指標(如在線交易額、用戶活躍度)進行監控與分析。

- 自動化數據攝入:替代傳統手動導出/導入,實現數據流程的自動化與可重復性。

二、 數據處理服務:數據的“煉油廠”

1. 核心定義

數據處理服務是一系列用于對原始數據(特別是從接口獲取的數據)進行加工、轉換、清洗和組織的工具、平臺或代碼流程的總稱。它的目的是將雜亂、原始的“原油”數據,提煉成干凈、統一、適合分析的“成品油”數據。

2. 關鍵處理環節

一個完整的數據處理服務通常包含以下環節:

- 數據抽取:從接口數據源等地方拉取數據。

- 數據清洗:處理缺失值、異常值、格式不一致、重復記錄等問題。

- 數據轉換:進行格式轉換(如時間戳標準化)、字段計算、數據聚合、維度退化等。

- 數據加載:將處理后的數據寫入目標存儲,如數據倉庫(如Snowflake、BigQuery)、數據湖或分析數據庫。這個過程常被稱為 ETL 或 ELT。

3. 常見形態

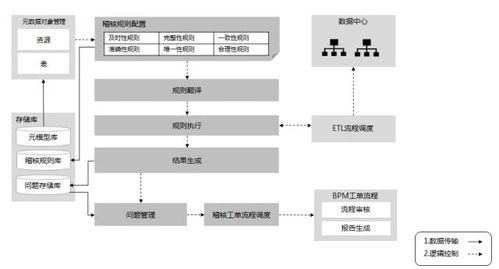

可視化ETL/ELT工具:如Apache NiFi、Talend、Informatica、阿里的DataWorks等,提供圖形化界面配置數據處理流程。

代碼/腳本驅動:使用Python(Pandas、PySpark)、SQL或Scala(Spark)編寫數據處理腳本,靈活性最高。

云原生數據處理服務:如AWS Glue、Azure Data Factory、Google Cloud Dataflow,提供全托管、可擴展的數據處理能力。

流處理引擎:如Apache Flink、Spark Streaming,專門用于處理實時接口流入的數據流。

三、 協同工作流:從接口到洞察

在實際的數據分析項目中,接口數據源與數據處理服務緊密協作,形成一個高效的數據流水線:

- 觸發與拉取:調度系統(如Airflow)或實時監聽器觸發任務,通過預定義的接口向目標系統請求數據。

- 原始數據落地:獲取的原始數據通常先被持久化到“數據湖”或暫存區,保留原始快照以備審計和重處理。

- 加工處理:數據處理服務啟動,對原始數據進行清洗、轉換、關聯和聚合,使其符合分析模型的要求。

- 服務與存儲:處理后的高質量數據被加載到數據倉庫或數據集市,結構化為易于查詢的星型/雪花模型。

- 分析與應用:BI工具(如Tableau、FineBI)、數據應用或AI模型從處理后的數據中獲取洞察,驅動決策。

四、 關鍵考量與最佳實踐

- 穩定性與監控:接口可能不穩定或變更,數據處理流程可能失敗。必須建立完善的日志、監控和告警機制。

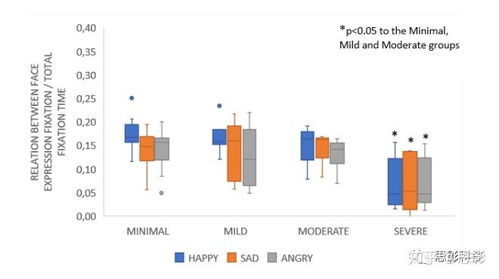

- 數據質量:在數據處理階段建立數據質量校驗規則(如唯一性、非空、值域檢查),從源頭保障分析結果的可靠性。

- 性能與成本:接口調用頻次、數據量大小直接影響處理速度和云服務成本。需要優化調度策略和處理邏輯。

- 安全與合規:接口認證(API Key、OAuth)、數據傳輸加密、敏感數據脫敏是必須遵守的安全底線。

###

接口數據源是數據分析的“源頭活水”,決定了你能獲得什么樣的原材料;而數據處理服務是核心的“加工引擎”,決定了原材料的品質和可用性。理解并熟練運用這兩者,是構建可靠、高效、可擴展的數據分析體系的基礎。在現代數據架構中,它們正朝著實時化、自動化、智能化的方向不斷演進,持續賦能數據價值的高效釋放。